L’obiettivo è unire i sensi umani in un’intelligenza multimodale creativa

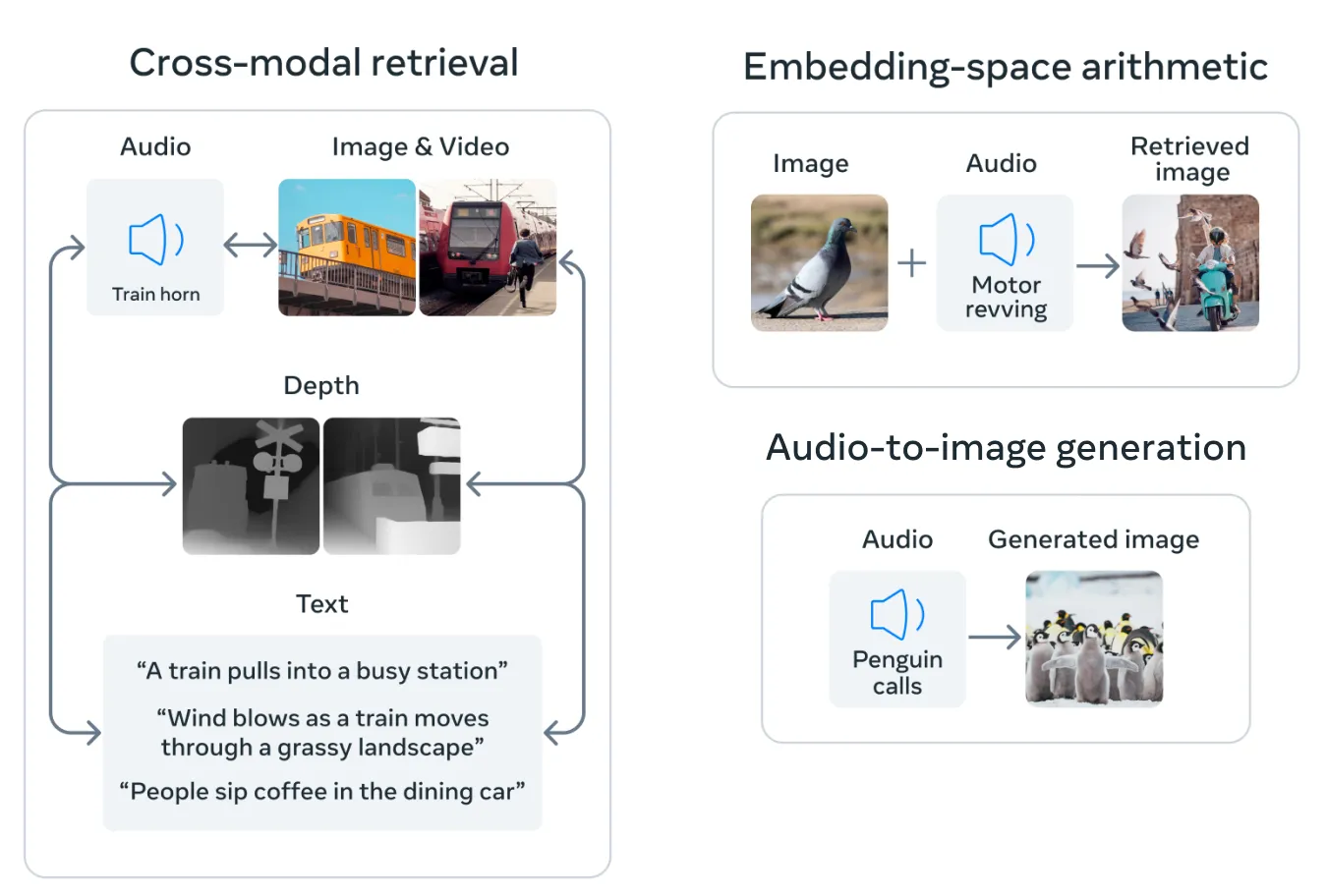

Lo strumento di intelligenza artificiale open source di Meta, chiamato ImageBind, può mimare la percezione umana. Cosa vuol dire? La piattaforma permette connessioni tra dati simili a come gli esseri umani percepiscono o immaginano un ambiente. Lo ha spiegato l’azienda con un aggiornamento sui suoi progetti di AI. “Mentre i generatori di immagini come Midjourney, Stable Diffusion e DALL-E 2 abbinano le parole alle immagini, consentendo di generare scene visive basate solo su una descrizione testuale, ImageBind lancia una rete più ampia. Può collegare testo, immagini/video, audio, misurazioni 3D (profondità), dati di temperatura (termici) e dati di movimento (da unità di misura inerziali) — e lo fa senza doversi prima addestrare su ogni possibilità”.

È una fase iniziale di un framework che potrebbe eventualmente generare ambienti complessi da un input semplice come un prompt di testo, un’immagine o una registrazione audio (o una combinazione dei tre). “Potresti vedere ImageBind come un avvicinamento dell’apprendimento automatico all’apprendimento umano. Ad esempio, se ti trovi in un ambiente stimolante come una strada trafficata della città, il tuo cervello (in gran parte inconsciamente) assorbe immagini, suoni e altre esperienze sensoriali per dedurre informazioni su auto e pedoni in transito, edifici, condizioni meteorologiche e molto altro. Gli esseri umani e altri animali si sono evoluti per elaborare questi dati per il nostro vantaggio genetico: la sopravvivenza e la trasmissione del nostro DNA”.

Quindi, se oggi usiamo Midjourney per creare immagini irrealistiche basate su prompt di testo, uno strumento di intelligenza artificiale multimodale come ImageBind potrebbe eventualmente creare un video del cane con suoni corrispondenti, tra cui un contesto suburbano dettagliato, la temperatura della stanza e le posizioni precise del cane e di chiunque altro nella scena. “Questo crea opportunità distintive per ottenere animazioni da immagini statiche combinandole con istruzioni audio”, hanno detto i ricercatori di Meta in un post sul blog per gli sviluppatori. “Nei tipici sistemi di intelligenza artificiale, esiste un incorporamento specifico (ovvero vettori di numeri che possono rappresentare i dati e le loro relazioni nell’apprendimento automatico) per ciascuna rispettiva modalità. ImageBind mostra che è possibile creare uno spazio di incorporamento congiunto in più modalità senza la necessità di addestrarsi sui dati con ogni diversa combinazione. Questo è importante perché non è fattibile per i ricercatori creare set di dati con campioni che contengono, ad esempio, dati audio e dati termici da una strada trafficata della città, o dati di profondità e una descrizione testuale di una scogliera sul mare”.

Meta ha un obiettivo: espandere la tecnologia oltre gli attuali sensi. “Se finora abbiamo esplorato i sei sensi nella nostra attuale ricerca, crediamo che l’introduzione di nuove modalità che colleghino il maggior numero possibile di sensi – come il tatto, la parola, l’olfatto e i segnali cerebrali – consentirà modelli di IA più ricchi incentrati sull’uomo”. Gli sviluppatori interessati a esplorare questa nuova sandbox possono iniziare immergendosi nel codice open source di Meta.