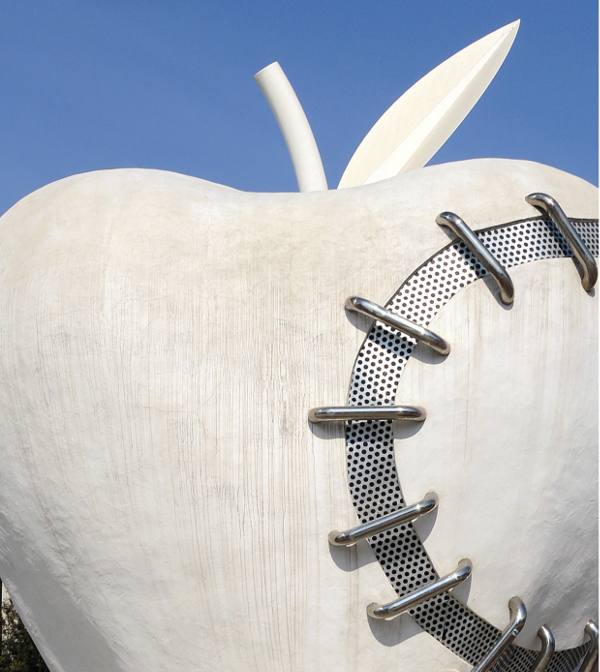

La trasformazione digitale è uno sport di squadra, non di rado abbiamo visto i CIO lasciati in panchina. I CIO ritornano protagonisti, riemergendo da quella “zona grigia” nella quale erano stati sprofondati dal Business negli ultimi dieci anni. Cambio di rotta. I CIO non sono più “brutti e cattivi”. Non sono più quelli che tengono “accese le luci” o tirano i cavi. Quelli rigidi e poco ready-to-business, capaci soltanto di trasformare le cose semplici in cose complicate. Quelli con cui molte aziende vendor in Italia non volevano parlare perché tanto non erano più loro a influenzare i budget di spesa. La complessità della trasformazione digitale e il fallimento di molti progetti hanno reintegrato l’IT nei ranghi dei board di amministrazione. Frattura ricucita tra IT e Business, come quella tra Tecnica e Natura, simboleggiata dall’opera monumentale di Michelangelo Pistoletto e installata permanentemente in Piazza Duca D’Aosta di fronte alla Stazione Centrale di Milano. La Mela Reintegrata rappresenta la ricomposizione degli elementi opposti. E a questo nuovo dialogo tra saperi Data Manager dedica la copertina. Una convergenza che vuole essere anche l’auspicio di una rinascita fuori e dentro le imprese, per la crescita e lo sviluppo del Paese. Dalla sinergia tra IT e Business dovrà scaturire la vera rivoluzione non solo in termini di efficienza e controllo dei costi, ma anche di innovazione dei modelli. Senza l’IT non si va lontano. Del resto, PayPal non è forse una IT per i pagamenti? E Octo Telematics non è una IT che ha cambiato le metriche del settore assicurativo? La contaminazione di conoscenze rappresenta un fattore indispensabile per una reale convergenza non solo tecnologica ma di visione di business. Le stesse ragioni che hanno portato alla separazione diventano il principio di un nuovo ordine, in cui le parti si ricongiungono, generando un nuovo equilibrio. Quando mettiamo tutte le “mele” nello stesso cestino – però – bisogna stare molto attenti a chi affidiamo il cestino. E adesso, che l’evoluzione dell’IT viaggia verso frontiere completamente nuove – dove ogni cosa è connessa e il rischio della perdita del controllo è reale – ci accorgiamo che la “regia” di questa convergenza deve essere nelle mani di chi è in grado di governare la tecnologia

La trasformazione digitale è uno sport di squadra, non di rado abbiamo visto i CIO lasciati in panchina. I CIO ritornano protagonisti, riemergendo da quella “zona grigia” nella quale erano stati sprofondati dal Business negli ultimi dieci anni. Cambio di rotta. I CIO non sono più “brutti e cattivi”. Non sono più quelli che tengono “accese le luci” o tirano i cavi. Quelli rigidi e poco ready-to-business, capaci soltanto di trasformare le cose semplici in cose complicate. Quelli con cui molte aziende vendor in Italia non volevano parlare perché tanto non erano più loro a influenzare i budget di spesa. La complessità della trasformazione digitale e il fallimento di molti progetti hanno reintegrato l’IT nei ranghi dei board di amministrazione. Frattura ricucita tra IT e Business, come quella tra Tecnica e Natura, simboleggiata dall’opera monumentale di Michelangelo Pistoletto e installata permanentemente in Piazza Duca D’Aosta di fronte alla Stazione Centrale di Milano. La Mela Reintegrata rappresenta la ricomposizione degli elementi opposti. E a questo nuovo dialogo tra saperi Data Manager dedica la copertina. Una convergenza che vuole essere anche l’auspicio di una rinascita fuori e dentro le imprese, per la crescita e lo sviluppo del Paese. Dalla sinergia tra IT e Business dovrà scaturire la vera rivoluzione non solo in termini di efficienza e controllo dei costi, ma anche di innovazione dei modelli. Senza l’IT non si va lontano. Del resto, PayPal non è forse una IT per i pagamenti? E Octo Telematics non è una IT che ha cambiato le metriche del settore assicurativo? La contaminazione di conoscenze rappresenta un fattore indispensabile per una reale convergenza non solo tecnologica ma di visione di business. Le stesse ragioni che hanno portato alla separazione diventano il principio di un nuovo ordine, in cui le parti si ricongiungono, generando un nuovo equilibrio. Quando mettiamo tutte le “mele” nello stesso cestino – però – bisogna stare molto attenti a chi affidiamo il cestino. E adesso, che l’evoluzione dell’IT viaggia verso frontiere completamente nuove – dove ogni cosa è connessa e il rischio della perdita del controllo è reale – ci accorgiamo che la “regia” di questa convergenza deve essere nelle mani di chi è in grado di governare la tecnologia

Nel dibattito attuale, tiene banco una sorta di dualità tra il tradizionale approccio al dato digitale visto con l’occhio quasi complice dell’informatico e il dato considerato invece dal punto di vista del business. Nel secondo caso, si parla di dato come “insight”, come correlazione tra circostanze apparentemente slegate, come proiezione verso il futuro. L’informatico per definizione ha una forte familiarità con i dati, le loro strutture, gli algoritmi che sottostanno al loro trattamento. I matematici e gli statistici – un mestiere sempre più complementare a quello dell’informatico – hanno dimestichezza con le grandezze, le curve, le geometrie che i dati rappresentano e con gli operatori, le funzioni che trasformano o mettono a confronto tali grandezze. Oggi – la vera sfida da affrontare – è mettere in relazione queste professioni con coloro che, all’interno dell’organizzazione aziendale, governano i processi attraverso cui si articolano la produzione e la commercializzazione di beni e servizi. Costruire, per dirla in altro modo, una “data science” che tenga conto delle esigenze di tutti, che ci permetta finalmente di colmare il gap tra la semplice automazione di un processo, di una attività di business e la sua piena digitalizzazione.

Alle tavole rotonde di Data Manager torna alla ribalta l’accoppiata Big Data e IoT, con un ricco excursus su una progettualità molto più ampia del previsto. Insieme al “nuovo petrolio”, dai giacimenti di dati emergono anche nuove regole di ingaggio per una tecnologia sempre più motore di business. IoT e Big Data vengono spesso assimilati. Nella Internet delle Cose la tecnologia della sensoristica e la presenza ormai generalizzata di intelligenza artificiale all’interno di dispositivi un tempo “stupidi” e privi di memoria, rende possibili la produzione e soprattutto la condivisione di informazioni associate a grandezze tipicamente analogiche espresse all’origine, sotto forma di misure direttamente “inputabili” in un computer. In fabbrica, possiamo avere a che fare con i parametri dimensionali di un pezzo, con la temperatura di fusione, con il numero di giri di una centrifuga e così via. Nell’ambiente naturale con la qualità dell’aria, con il livello delle precipitazioni, la velocità e la direzione del vento. Nelle città, in cerca di un approccio più smart alla loro gestione, i big data sono il numero di autovetture ferme a un semaforo, la posizione di un autobus urbano, le immagini che arrivano dalle videocamere di sorveglianza. Una varietà infinita di valori che in passato abbiamo imparato a misurare e digitalizzare, ma che oggi la “I” di IoT ci aiuta a condividere nativamente con i sistemi informatici, realizzando quella piena convergenza tra Information Technology e Operation Technology (appoggiata alla rivoluzione 5G) da cui dovrà scaturire la vera evoluzione in termini di efficienza, controllo dei costi, redditività di tutte le attività direttamente o indirettamente abilitate, o anche semplicemente affiancate, “assistite” dalle tecnologie informatiche. In particolare, da un software che diventa a sua volta sempre più intelligente e aperto al valore cognitivo, “semantico” del dato, pronto a regalarci l’insight di una realtà diversa da quella che i dati descrivono.

Tavola Rotonda Big Data e IoT, senza l’IT non si va lontano

CIO SEMPRE PIÙ IBRIDI

È un cammino lungo, un viaggio che dobbiamo percorrere e che dobbiamo cercare di pianificare al meglio, raccogliendo tutta la conoscenza che serve, creandola dove manca. Con questa tavola rotonda cerchiamo di indicare la strada verso la digitalizzazione del business, partendo da concrete esperienze e considerazioni in materia di strategie di valorizzazione del dato, di convergenza tra IT e OT, di reclutamento e formazione di nuove figure professionali “ibride” o interdisciplinari, di management orientato all’integrazione di dati e insight nei processi di business. Come di consueto, sono stati invitati a partecipare alla discussione e allo scambio di esperienze i rappresentanti di un significativo campione di settori industriali e pubblici amministratori. A loro Data Manager ha chiesto di illustrare le rispettive strategie in materia di big data e analytics di nuova generazione, di convergenza tra tecnologie informatiche e OT (operational technologies) nelle aziende di produzione e più in generale dell’applicazione delle tecnologie della Internet delle cose. Durante il confronto sono certamente emerse diverse difficoltà a livello di competenze, leadership, organizzazione interna, sicurezza e compliance, ma anche le strade seguite per aggirare gli ostacoli, anche facendo leva sulle partnership con le società che oggi presidiano l’offerta di soluzioni e servizi di consulenza.

Daniela Rao, senior consulting & research director di IDC Italia ha illustrato durante la sua introduzione i risultati di una recente indagine europea sulle applicazioni analitiche, condotta sulle aziende con oltre cento addetti (130 le aziende italiane rappresentate). «Si può concludere – ha detto Daniela Rao – che i progetti basati sulle applicazioni analitiche, con tutta la componente statistico-predittiva, si stanno affermando, a partire dalle grandi aziende, tra le attività distribuite sull’intero territorio». Secondo l’indagine IDC aggiornata al 2018, questi tool sono utilizzati da un terzo delle imprese e un altro 65% li sta valutando o prevede già di utilizzarli. Un’osservazione interessante riguarda la forte percentuale di rispondenti (ancora una volta circa il 65%) che afferma di utilizzare o di avere intenzione di utilizzare il cloud come piattaforma di integrazione e gestione dei dati raccolti alla periferia delle reti e concentrati con finalità analitiche in data center sempre più ibridi. Dato che – secondo l’analista – rappresenta un ulteriore sintomo di maturazione. Le soluzioni IoT cloud dominano anche nelle applicazioni di connettività dati, controllo industriale e gestione di dispositivi e infrastrutture.

«La sperimentazione con diverse modalità di approccio di raccolta e analisi sta ancora caratterizzando il mercato italiano dell’IoT» – ha poi spiegato Daniela Rao, riportando che se la percentuale di risposte più elevata (circa il 50%) riguarda l’analisi effettuata direttamente sull’edge o sul dispositivo interconnesso, comincia a emergere (circa un terzo delle esperienze citate) anche il modello della concentrazione di tutti i dati in un data lake, il nuovo paradigma che aggiorna la cultura del data warehouse in chiave Big Data. Aumentano di conseguenza anche le stime di valore di un mercato che comincia a diventare consistente in Europa. L’intero comparto unificato IoT, Big Data e strumenti analitici vale quest’anno oltre 294 milioni di dollari nella regione EMEA e nel 2021 dovrebbe rappresentare, con quasi mezzo miliardo di dollari, un terzo della torta globale di 1,8 miliardi di dollari. Da questa parte dell’oceano, insomma, il combinato IoT Big Data dovrebbe quadruplicare nel quinquennio iniziato nel 2016.

SUL BINARIO DELLA DATA SCIENCE

Un primo processo di accentramento – ha spiegato poi Stefano Casalegno, responsabile unità Data Science & Digital Transformation di Ferrovie dello Stato – è stato deciso dalla holding del gruppo ferroviario pubblico. «Fino a tre anni fa – ha raccontato Casalegno – un unico centro di innovazione non esisteva, le attività si svolgevano a livello delle singole società del gruppo». È stata la volontà dei vertici aziendali e dell’allora direttore ICT Gianluigi Castelli, oggi presidente, a portare alla creazione di una struttura composta di unità come “Open innovation”, “Innovation governance” e altre impegnate nell’esplorazione ma anche nel coordinamento delle novità che possono avere una ripercussione immediata sull’evoluzione di Ferrovie dello Stato e della sua presenza a livello nazionale e internazionale. Il primo progetto di Casalegno, reclutato nelle file della divisione Data Science mentre era ancora impegnato in Gran Bretagna nel settore delle tecnologie satellitari e delle startup universitarie, è stata l’organizzazione di un workshop aperto ai responsabili ICT delle società del gruppo – con una prima fase – destinata a raccogliere un quadro di insieme sulle sensibilità e il modo di lavorare – e una seconda fase – mirata, attraverso seminari specializzati, a valutare il potenziale di specifiche applicazioni analitiche e dell’uso di un unico data lake condiviso. L’iniziativa ha partorito dieci proposte di lavoro che sono state approfondite. Nei mesi successivi, Casalegno ha fatto realizzare diversi progetti pilota che sono stati presentati al Gruppo.

Tra gli esempi, Casalegno ha citato un progetto pilota proof of concept svolto con la controllata olandese Qbuzz, società titolare del trasporto pubblico a Utrecht e Groningen, dove una squadra di data scientist ha analizzato i flussi di comunicazione verso gli utenti e quelli tra gli autobus – «veri sensori IoT mobili» – ha detto Casalegno – e la centrale operativa, con la finalità di ottenere, attraverso l’analisi semantica, insight utili per la risoluzione dei problemi e per una misurazione più precisa della qualità del servizio. Le applicazioni sperimentate sono già molto variegate e coinvolgono diversi soggetti sia pubblici che privati: si va da una app utilizzata dalle forze dell’ordine per avere più sicurezza a bordo dei treni regionali pugliesi, alla intelligenza artificiale sviluppata su Alexa di Amazon per fornire informazioni di viaggio ai clienti Trenitalia. «In Francia, un player come BlaBlaCar oggi offre servizi di trasporto dopo l’acquisizione di Ouibus» – ha aggiunto Casalegno. «Questo dà l’idea di quanto dobbiamo correre per stare al passo della tecnologia» – ha concluso il coordinatore delle attività Big Data di FS, citando anche le ricerche svolte, con strumenti IoT, nel campo della logistica dei trasporti e della manutenzione predittiva. Tante attività che vengono approcciate con una tattica basata su piccole squadre di lavoro molto dinamiche e il costante tentativo di internalizzare nuove competenze con una attenzione alla multidisciplinarità. «Gli ingegneri ferroviari non bastano più, abbiamo bisogno di team eterogenei con visioni diversificate per affrontare problemi che non si risolvono più in modo tradizionale».

LA TRASFORMAZIONE NELLA PA

Un’altra realtà, questa volta pubblica, che vanta una cultura approfondita, proveniente dalla storia dei sensori è ARPA, l’Agenzia regionale per la protezione dell’ambiente della Regione Lombardia. Graziella Dilli, responsabile dell’unità organizzativa complessa ICT e CIO di ARPA Lombardia, riferisce di una rete di quasi cinquemila sensori distribuiti in diverse centinaia di centraline che raccolgono dati meteorologici, geologici e di qualità dell’aria e vengono messi a disposizione in tempo reale alla Protezione Civile per l’allertamento alla Popolazione. Sulla base di questi dati sono state sviluppate applicazioni rivolte al pubblico per la disseminazione di informazioni in tempo reale. «Abbiamo accumulato un discreto patrimonio di dati che abbiamo cominciato a mettere a disposizione in modalità open data e nel Portale E015 della Regione Lombardia» – spiega Graziella Dilli. «Pubblichiamo informazioni in modo via via più strutturato anche all’esterno della Regione, per esempio, nel contesto del bacino del fiume Po. Il passo successivo è costituito da modelli previsionali più sofisticati, da cui trarre informazioni sulle vere urgenze ambientali. È un salto complesso, che richiederebbe un investimento in strumenti di nuovo tipo». Graziella Dilli sottolinea che un primo lavoro di classificazione di questo patrimonio è stato avviato.

Un altro aspetto è quello organizzativo. Giunta nella PA, dopo una carriera caratterizzata da molteplici esperienze e ruoli diversi, dalla gestione e sviluppo dei sistemi informativi interni al supporto tecnico – Graziella Dilli afferma di aver fatto un percorso di costruzione progressivo del team ICT, grazie al mandato della Direzione Generale che ha consentito gli investimenti necessari in risorse umane e infrastrutture. Il team e le dotazioni di ARPA nel tempo sono cresciuti molto sia tecnicamente che sull’innovazione, ma anche sul piano della governance». L’IT di ARPA riesce dunque ora a contribuire alla digitalizzazione dell’Agenzia con iniziative come la mobilità, l’adozione di un cloud ibrido, cercando di semplificare i processi con la tecnologia e di coinvolgere tutti i componenti dell’Agenzia nella trasformazione digitale (Graziella Dilli è il responsabile della trasformazione digitale di ARPA Lombardia), anche con progetti, come per esempio l’introduzione dell’ERP, che vedono strettamente collaborare ICT e tutte le funzioni dell’Agenzia.

ACCESSIBILITÀ E CONVERGENZA

Il tema che si delinea intorno al tavolo riguarda dunque il dato, e il suo valore pratico. «Un passo avanti significativo» – sostiene Diego Ravazzolo, manager di Data Reply. «Solo pochi anni fa, c’era proprio un problema di disponibilità dei dati. Con l’andare del tempo, il dato è diventato gradualmente disponibile, anche se non del tutto accessibile. Oggi, il trend della disponibilità e dell’accessibilità esplode, e nasce il problema di che cosa fare». L’adozione di piattaforme tipiche di Big Data è legata essenzialmente ai volumi di dati che siamo chiamati a gestire. Un passaggio obbligato che non tutti sono pronti a effettuare perché nella realtà IT e OT non sono per niente facili da integrare. «E noi consulenti siamo a fare da ponte. In molti casi, dalla cultura delle operations è assente l’attenzione alla gestione del dato e della sua sicurezza. Le problematiche sono simili, ma devono essere affrontate in modo diverso». Sul problema centrale della convergenza operata in ottica Industry 4.0 interviene Mirco Destro, che svolge la funzione di Group CIO in seno a AFV Acciaierie Beltrame. Una realtà che per la varietà di prodotti creati in sette stabilimenti, numero di clienti e problematiche anche logistiche da risolvere (cinquecento tir operativi ogni giorno sui sette punti di consegna), Destro definisce come – «una sorta di supermercato dell’acciaio». Anche Destro prova a dare una risposta all’interrogativo sull’impiego del “petrolio grezzo” digitale. Tematiche come la manutenzione predittiva vengono ormai a decadere a favore di una progettualità più avanzata. «Intanto, stiamo collezionando i dati prodotti da centinaia di sensori in un data lake» – sottolinea Destro. Uno degli obiettivi principali, per un’azienda energivora come la nostra, che consuma più dell’intera città di Vicenza, è la maggiore efficienza energetica». Fuori dal ciclo produttivo, nascono i problemi con la circolazione del prodotto che resta fermo negli stabilimenti. Anche in questo caso, miglioramenti di pochi punti percentuali possono significare enormi risparmi e marginalità.

OLTRE LA MANUTENZIONE PREDITTIVA

Nel corso della discussione, Destro interviene più volte sulla questione del diverso rapporto tra IT e Business, reso possibile dalla nuova cultura analitica legata ai big data. «I fornitori di tecnologie parlano nella maggior parte dei casi di manutenzione predittiva. Ma da quello che sento dire oggi, c’è l’opportunità di coprire l’intero spettro del business. Senza però mettere da parte l’IT: c’è molto lavoro per tutti». L’invito sembra dunque essere quello di assumere una mentalità ancora più aperta nei confronti delle possibili applicazioni della nuova scienza dei dati, cercando di costruire un rapporto tra tecnologie e business che sembrava essersi esaurito in una lunga fase di automazione di processi tradizionali, caratterizzata sì da una maggiore efficienza ma carente sul piano della creatività. Francesco Pezzutto, CIO di Vimar – colosso della domotica, della building automation e della sicurezza fisica da 1.500 dipendenti in otto stabilimenti e una produttività da 200 milioni di pezzi all’anno – si sofferma su due progetti dove la sinergia tra IT e Business sembra dimostrare tutte le sue potenzialità. «Sfruttando gli incentivi per l’Industry 4.0 abbiamo portato avanti un piano di smart manufacturing, sviluppando su una unica piattaforma l’ambiente ERP e il controllo della produzione, anche qui integrando i tre aspetti della lavorazione della materia prima tramite stampaggio, della lavorazione meccanica con assemblaggio e infine della rifinitura». Oggi, la fabbrica Vimar è governata in modo digitale con il pieno coinvolgimento della parte operations: «I capiturno vedono attraverso una dashboard ogni momento della produzione con stime sull’andamento e sugli interventi di manutenzione programmata». Un sistema – aggiunge Pezzutto – che ha ovviamente generato una quantità di dati su cui l’azienda si sta interrogando. La parte di controllo della produzione c’è, ma la domanda è su quali potrebbero essere gli sviluppi futuri. Il CIO di Vimar intuisce che possano esserci risvolti sia sul piano della qualità della produzione sia su quello delle applicazioni dei prodotti sul campo, ma avverte anche la necessità di seguire un approccio che lasci spazio a fattori esterni: tipicamente, la competenza di consulenti e data scientist “forti” nella loro disciplina.

Il secondo progetto di Vimar riguarda una nuova modalità di tracciamento del prodotto basato su una diversa misurazione dei materiali assemblati e del prodotto finito nelle sue destinazioni, con informazioni che possono servire per controllare meglio o anticipare il comportamento dei dispositivi nel tempo. Pezzutto parla anche di applicazioni lato business, come la «domotica facilitata» da servizi legati all’uso dei prodotti da erogare in cloud, e – nel sottolineare l’importanza dell’evoluzione tecnologica, che ha reso per esempio possibile elaborazioni in tempo praticamente reale – segnala anche il rapporto tra IT e organizzazione, dove le due componenti influiscono l’una sull’altra. «La nostra strategia IT è condivisa col Business, insieme vediamo le tecnologie di oggi e di domani e le decliniamo in roadmap e iniziative». Un’ultima considerazione riguarda la cybersecurity. «Con la domotica in cloud i confini non sono più quelli della fabbrica o del singolo prodotto, cogliendo le opportunità dell’adeguamento al GDPR, Vimar sta rivoluzionando anche la compliance, con un piano di formazione mirato a creare una diversa cultura tecnica e comportamentale».

VIRTUALIZZAZIONE E DISPONIBILITÀ

In un business destinato a ruotare sempre più intorno al dato, il messaggio di Antongiulio Donà, VP sales Italy di Talend, provider di tecnologie di data integration, è di “fidarsi” maggiormente del business. «Il business – avverte Donà – sa di che cosa ha bisogno. La tematica importante dal nostro punto di vista è la disponibilità di questi dati in modalità self-service». Il primo punto da affrontare è dunque il problema della messa a disposizione di dati di qualità, della veridicità del dato. E in questo, il ruolo dell’informatico è fondamentale, perché essere in grado di offrire all’azienda gli insight che servono a un business competitivo e reattivo ha anche un effetto liberatorio dagli eccessivi legami che contraddistinguevano la “vecchia” informatica. «Sentiamo dire spesso che l’IoT non decolla perché mancano veri standard di riferimento. Le soluzioni open source di Talend danno all’IT la capacità di occupare spazi diversi, di lasciare che lo “standard” venga stabilito da chi ha bisogno dei dati e li utilizza». L’ICT non deve essere più quel “centro di costo” che imprigionava il business, lascia intendere Donà che esorta data scientist e manager aziendali a non ripetere gli errori fatti con la prima generazione di data warehouse. «Prestate più attenzione alla qualità dei dati che raccogliete nei vostri data lake. La potenza dell’IT oggi è clamorosamente cambiata, e vi offre il controllo del total cost of ownership anche in futuro, quando i data lake esploderanno davvero».

Un’altra voce impegnata sul fronte della fase che precede l’analisi è quella di un operatore come Denodo, un’azienda nata come spin-off universitario in Spagna, incorporata in California e recentemente sbarcata in Italia per iniziativa di Gabriele Obino, intervenuto al tavolo in veste di country manager di questa realtà nuova per il mercato italiano. Denodo, come Talend anche se a un livello diverso, si occupa di disponibilità del dato, proponendo un paradigma di virtualizzazione che consente di risolvere il problema della corretta gestione dei dati utilizzati in una molteplicità di applicazioni, attraverso la creazione di repliche. Costose da gestire e complesse da tenere sempre allineate e in sincronia con i dati originali. Indipendentemente dalla tipologia di piattaforma utilizzata per archiviare questi originali. «È vero, collezionare i dati in un data lake non basta. In questo modo, non hai avvicinato il dato al business» – avverte Obino. «L’idea di Denodo consiste nel disaccoppiare il dato grezzo da tutti gli aspetti informativi, perché solo dalla piena interconnessione può nascere una semantica comune a tutti i nostri dati». Denodo, in altre parole, separa la fase del governo dei dati dalle “technicalities” (la collocazione, i formati, i linguaggi di interrogazione), senza però creare tra i due livelli una barriera insormontabile, ma favorendo quell’approccio olistico che evita di ricreare gli antichi silos di competenze.

La vera lezione è che all’interno di una azienda data driven si deve costituire un nuovo patto tra tecnologia e business. Un’alleanza mirata non tanto a individuare una risposta uguale per tutti, quanto a formulare le domande giuste. Anche un CIO di lunga esperienza come Fabio Degli Esposti, responsabile delle infrastrutture informatiche di SEA Aeroporti di Milano, ammette di avvertire ancora un senso di immaturità. «Se stiamo ancora qui a parlare tanto di una tecnologia, significa che in qualche modo il “bandolo della matassa” non è stato trovato, malgrado la discreta dose di progettualità emersa finora. È indubbio che l’IoT non è un “nice to have”, ma rappresenta un’opportunità per coniugare business e digital. Per quanto mi riguarda, da grande ho deciso di diventare DIO, digital information officer».

DIGITAL INFORMATION OFFICER

Degli Esposti illustra la sua nuova carriera parlando di ciò che bolle in pentola negli aeroporti milanesi. I quali – come tutti i grandi aeroporti – hanno un grande problema di navigazione interna dei dati e di flussi di informazioni, oggi affrontato con un mix tecnologico di Beacon, sensori Bluetooth e termocamere. Dall’altro lato c’è una questione meramente infrastrutturale, di impianti, reti, condizionatori ambientali, illuminazione, che generano un enorme volume di dati che Degli Esposti riconosce come – «leva importantissima» di risparmi e ricavi. «Non è solo questione di big o small, i dati devono essere preziosi, conosciuti, referenziati, ma non deve essere un problema di data scientist. Dobbiamo riuscire a integrare nella scienza del dato la consapevolezza del business». Un lavoro di contaminazione, conclude il CIO di Sea Aeroporti (e futuro DIO), che rappresenta una grande occasione di rilancio di funzioni tecnologiche che il top management comincia a percepire in modo molto diverso.

In questa forte richiesta di ibridizzazione, si ritrova Alessandra Cavalletti, product manager Smart Cities & New Business di Engie Services, braccio B2B dell’operatore energetico Engie focalizzato sulla produzione da rinnovabili. In Italia, l’azienda concentra le competenze dei servizi per la PA e la smart city. «A livello globale Engie vanta diverse specializzazioni, come la mobilità urbana per il Brasile, la videosorveglianza in Francia. In Italia, i servizi energetici a carattere territoriale, il teleriscaldamento, l’illuminazione. Trasversalmente a questi tre filoni ci sono gruppi che si occupano di IoT e lavorano, per esempio, sulle piattaforme di interconnessione». Non a caso, interconnessione è un’altra delle parole chiave che contrassegnano questa tavola rotonda. «Quando gestisci una rete di corpi illuminanti e videocamere, le applicazioni possibili vanno da un lampione capace di dare più luce sul luogo di un incidente, o a un’integrazione che permette all’amministrazione locale di informare i cittadini al volante sui percorsi più scorrevoli. I dati sono tanti, solo mettendoli insieme, riusciamo a estrarre informazioni che prima non esistevano». L’esperta di Engie Services mette sul tavolo un importante tema di riflessione: «Quante volte parliamo di processi e quante poche di prodotti» – sintetizza Alessandra Cavalletti. «A proposito di trasversalità delle figure professionali, ricordo che non stiamo creando nuovi prodotti bensì nuovi processi e questi hanno bisogno dell’informatico e dello scienziato dei dati. Nei nuovi team che vengono formati, la parte business è diventata così potente perché la curiosità, nello sviluppare un nuovo processo, scatena una creatività che va oltre i classici modi di ragionare».

RCA AUTO, LA RIVOLUZIONE DELL’IOT

In questo senso, l’ospite a questo tavolo che più di tutti ha saputo andare oltre la tradizione è Octo Telematics, che sfruttando l’interconnessione di oggetti molto particolari, le automobili, ha rivoluzionato il mercato assicurativo RCA. «Sugli oggetti interconnessi mobili e no, abbiamo costruito un intero business» – rileva Francesco Tomasoni, che in Octo riveste l’inedito ruolo di commercial support director. Sette milioni di auto, decine di migliaia di case, animali domestici. Con i nostri servizi, al 95% assicurativi, abbiamo una quota di mercato mondiale pari al 44%». L’approccio alle domande poste all’inizio del lungo round di discussioni è stato definito già cinque anni fa. Come risolve Octo Telematics la questione del trasferimento di valore dal dato grezzo al business? «Abbiamo la fortuna di avere una grossa leva sostanziale, perché oltre al dato in sé raccogliamo il “fenomeno”, il comportamento di guida e, attraverso i nostri servizi di pronto intervento, registriamo anche eventi complessi, i sinistri, che definiscono fenomeni cui afferiscono centinaia di migliaia di record». Il racconto di Tomasoni tradisce molto della sua carriera professionale in Octo, dove per tre anni si è occupato proprio di Big Data Advanced Analytics. La ridefinizione dell’assetto proprietario in Octo Telematics ha proiettato il manager informatico verso una nuova missione, quella di trovare una risposta alla domanda: che cosa facciamo del nostro data lake?

«La nostra carta vincente è la possibilità di confrontare i dati grezzi con fenomeni documentati e certificati dagli assicuratori». Forte di questo giacimento, Octo Telematics ha sviluppato una struttura di “presentazione” dei dati con migliaia di variabili in grado di “autopesarsi”. In pratica, algoritmi in grado di decidere da soli i parametri-chiave. Applicato all’ambito del sinistro, questo motore decisionale è oggi in grado di offrire agli attuari dell’assicurazione un sistema di tariffazione alternativo, basato su ben centodieci microprofili di guida. Interessante, anche il modello finanziario che ha sostenuto la fase di ricerca, partito da un investimento iniziale di Octo Telematics e trasformato in un accordo di revenue sharing con tre compagnie assicurative. A proposito della dualità molto dibattuta tra dato grezzo e dato derivato – Tomasoni consiglia – sull’onda di quanto detto anche da Gabriele Obino, di cercare di tenere disaccoppiati i due momenti. «Nel nostro progetto, insieme al partner analitico, abbiamo cercato di costruire una practice capace di far sì che l’utente finale potesse navigare autonomamente nei dati, tarando i parametri scelti. In poche ore il modello è in grado di generare valore. Se l’IT del Gruppo si è sentita un po’ bypassata da questa modalità, anche i commerciali hanno dovuto adeguarsi. È stata un’esperienza davvero trasformativa».

Come è stato rivisto, in definitiva, il ruolo dell’IT in Octo Telematics? La duplice curva che in passato definiva il focus degli informatici sugli aspetti dell’infrastruttura IT e dello sviluppo e manutenzione delle blackbox da installare nelle auto o negli appartamenti – conclude Tomasoni – si è spostata verso certi aspetti della delivery per poi tornare a concentrarsi sulla sicurezza, sulla business continuity. «Quello che un tempo era un ruolo di configurazione della “macchina” informatica, oggi si sposta verso la compliance, abbiamo introdotto temi più interdisciplinari, come la data quality assurance, lo SLA contract management verso i sourcer. Il CIO diventa un contract manager, c’è molta più integrazione trasversale». Quale lezione finale possiamo trarre da questa sessione intensiva di studio del fenomeno IoT e Big Data? Forse, la sintesi più efficace è quella raggiunta da Antongiulio Donà di Talend. «Il business sta trovando un valido braccio nell’IT. Anzi, un’intera squadra di bracci destri».

Testi di Andrea Lawendel e Giuseppe Mariggiò

Foto di copertina Gabriele Sandrini